Mivel előző hasonló jellegű cikkünk, a “De mi az a Mantle,

és miért lesz jó nekünk?” nagy sikert aratott, úgy gondoltuk, nem árt

megemlékezni arról, hogy bizony az Nvidia is igyekszik a játékosok kedvére

tenné, és nem csak az erősebb videokártyákkal. A hardcore PC-s játékosok mindig

is az Nvidia legfontosabb célcsoportja volt, hiszen jellemzően a zöld cég

kínált olyan erős (és az esetek többségében jelentősen túlárazott) kártyákat,

melyekkel egyrészt az AMD már nem tudott versenyezni, másrészt pedig amiket

pontosan ez a réteg tudott megvásárolni. Erre remek példa az ezer dolláros

árcédulával piacra dobott GeForce GTX Titan, ami ugyan alapvetően nem is a

játékosoknak szólt (hiszen erősen felpumpált, dupla pontosságú compute-ban

büntetett), mégis nagy sikere lett a keményvonalas játékosok legfelső, sokat

költeni képes rétegeiben.

Érdemes látni, hogy aki megengedhet magának drága videokártyákat és drága

processzorokat, az a grafika minőségét tekintve a következő generációs konzolok fölé mehet némileg (igaz, sokszoros áron), azonban

van ennél egy fontosabb tényező is. Ez pedig a képminőség, amivel még a

következő generációs konzolok sem fognak tudni vetélkedni. Ma már itthon is realitás, hogy a legtöbbünk rendelkezik olyan erős PC-vel, hogy mindent 1080p-ben tudjunk futtatni, MSAA-val

vagy supersamplinggal, de a nálunk szerencsésebb gazdasági helyzetben lévő

országokban, ahol a hardverek árai jóval olcsóbbak, már egyáltalán nem ritka,

hogy a keményvonalas játékosok az 1440p-s, vagyis a 2560x1440-es felbontású

monitorokat favorizálják.

Nem kérdés, hogy aki ilyen sokat költ hardverre, az nem csak, hogy minden

beállítást ultrára akar tenni, hanem a maximális képminőségre törekedik, nem

szeretne recés éleket látni, és zizegést sem akar tapasztalni. Azonban akad még

egy területe a képminőségnek, amire viszont eddig nem nagyon volt megoldás,

bármilyen erős hardverünk is legyen. Ez pedig a monitor frissítési

frekvenciája, ami továbbra is fix - a legtöbb esetben 60hz, de a fentebb is

említett, nagyobb felbontású példányoknál már jellemzően 120hz vagy 144hz. A

probléma, hogy renderelheti a gépünk bármilyen sebességgel az adott játékot, ha

a monitor csak bizonyos időközönként frissít, akkor bizony jönnek a problémák.

Ennek megoldására találták ki a V-syncet, ami a monitor képfrissítéséhez

igazítja a VGA által kiszámolt képkockákat.

Ez egészen addig jó is, amíg a gépünk gyorsabban renderel, mint ahogy a monitor

frissít - tehát, ha mondjuk a 60hz-es monitorunkhoz 80fps-sel fut a Battlefield

3, akkor minden fasza. Azonban, ha 60fps alá esik, akkor a monitor kénytelen megtartani az előző

képkockát, ami egy parányi akadást eredményez. Éppen ezért sokan kikapcsolva

tartják a V-syncet, ami viszont egy másik problémát hoz magával: elkezd

szakadni, törni a kép. Érezhető tehát, mi itt a gond: megvan a hardverünk

ahhoz, hogy élvezzük a legjobb grafikát, és eltüntessük a recés éleket, de még

a legjobb gép is folyamatosan változó fps-sel tudja csak renderelni a játékokat

(ráadásul az 1440p, vagy a 4k terjedésével nehezebb tartani a mostani

hardverekkel például a fix 120, vagy 144fps-t), így a monitor jelenti ebben az

egész folyamatban az utolsó szűk keresztmetszetet a tökéletes képminőség

eléréséhez.

Ennek megoldására találta ki az Nvidia a G-syncet, ami egy csapásra megszünteti

a monitorok fix frissítési frekvenciáját, és teljesen dinamikussá változtatja

azt, így a monitor mindig pontosan akkor frissíthet, amikot a VGA elkészült egy

képkockával, tehát a kettő teljesen szinkronban működhet egymással. Nem tudni,

mi a G-sync felső határa, de az Nvidia egyelőre egy 144hz-es Asus monitorral

demózta a cuccot, az alsó limit pedig 30hz, hiszen 30fps alatt már a játék

szaggatni kezd, így ilyenkor a G-sync minden képkockát megdupláz. Az eredményt

persze nem lehet látni sem videókon, sem képeken, ezt majd minden érdeklődőnek

élőben kell tesztelnie, mindenesetre akik látták működés közben, arról számoltak

be, hogy a végeredmény nagyon meggyőző, és tényleg eltűntet minden képhibát,

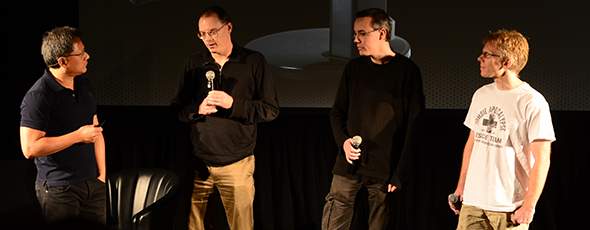

ami korábban a szinkronizációs probléma miatt előjött. Tim Sweeney a legnagyobb lépésnek nevezte az SD-ről HD-re váltás után, de ott volt még az Nvidia bemutatóján Johan Andersson és John Carmack is. Nem lehet eléggé hangsúlyozni, mennyire fontos volt a hardcore PC-s játékosok számára, hogy végre megszűnjenek a mikro-akadások és képtörések.

Mindezt persze nem olyan könnyű elérni, ugyanis az LCD megjelenítők nem

véletlenül dolgoztak eddig fix frissítéssel, ha ettől elszakadunk, mindenféle

egyéb nem kívánt hatás jöhet létre. Éppen ezért az Nvidia úgy tudta mindezt

megoldani, hogy egy külön modult fejlesztett, amit aztán be lehet majd építeni

az ezt támogató monitorokba, illetve természetesen maguk a gyártók is kínálnak

majd olyan monitorokat, melyekbe már alapból beletették a G-sync modult - ezek a monitorok valamikor a következő hónapokban jelennek meg, és habár árat nem tudunk még, arra érdemes készülni, hogy nem lesz olcsó mulatság. Hogy

mi található a modulon, azt egyelőre nem részletezte az Nvidia, de a kiadott

hivatalos fényképen látszik maga a vezérlőchip, és háromszor 256MB memória. Érdemes

továbbá megjegyezni, hogy a G-sync használatához nem csak a megfelelő monitorra

lesz szükségünk, hanem legalább egy GeForce GTX 650 Ti Boost vagy annál jobb

videokártyára, R331.58-as verziójú vagy újabb meghajtóra, illetve Windows

7/8-ra, valamint az egész történet kizárólag DisplayPorton keresztül működik.

Streamelés, játékfelvétel

Nem a G-synchez kapcsolódik, de érdemes legalább pár sorban megemlékezni arról

is, hogy az Nvidia más területeken is igyekszik előzni. Az egyik ilyen új

szolgáltatás az Nvidia Game Streaming, aminek segítségével a PC-n futtatott

játékot tudjuk egy az egyben streamelni WI-FI-n keresztül a Shield

kézikonzolra. Ez nyilván egy kényelmes módja lehet annak, hogy rendes

PC-játékokat élvezhessünk a vécén az androidos konzol segítségével. Legalábbis

más hasznát egyelőre nem látom, ezek a technológiák akkor lesznek igazán

hasznosak, ha már a neten keresztül is olyan késleltetést tudunk elérni, mintha

az otthoni WI-FI-re csatlakoznánk.

Ennél talán érdekesebb a Shadow Play, amivel az Nvidia a next-gen konzolok

funkcionalitásának egy darabját szeretné meghonosítani PC-n is. A Shadow Play

gyakorlatilag folyamatosan rögzíti játékunk közben az utolsó (maximum) 20

percet a merevlemezünkre. Azonban alapvetően ez csak bufferként működik, tehát

a program magától nem menti ezt le, és nem tölti meg feleslegesen a vinyónkat,

hacsak nem nyomjuk meg az ALT+F10 billentyűkombinációt. A Shadow Play tehát

lehetőséget ad arra, hogy ha valami nagyon látványos dolgot csináltunk, akkor

egy gombnyomással lerögzítsük az előzőleg felvett 20 percet, egyébként pedig a

program folyamatosan dobja el felvételeket. A legfontosabb azonban, hogy a cucc

a GeForce GTX 600 és 700-as GPU-kba épített hardveres H.264 kódolót használja,

így például 1080p 60fps-es felvétel mellett nem vágja úgy oda a teljesítményt,

mint mondjuk a FRAPS - körülbelül 5-10% a büntetés csak, és rögtön kapunk egy

frankón tömörített mp4 fájlt.

Az Nvidia lemaradt a következő generációs konzolokról, éppen ezért láthatóan

igyekszik, hogy még jobban kedvezzen a PC-s játékosoknak. A korábban elindított

GeForce Experience már egy remek lépés volt annak irányába, hogy a konzolokhoz

hasonlóan a felhasználóknak ne kelljen a grafikai beállítások között

turkálniuk, a Shadow Play pedig egy újabb konzolos funkciót költöztet PC-re

egyszerűen, magától értetődően. A G-sync egy régi és fontos problémára

jelent megoldást, amit már most epekedve várnak a megfelelően eleresztett

hardcore játékosok, hiszen elhozza az utolsó szükséges lépést a képminőség

javulásához. Hogy ezek ellen az AMD és a Mantle hogyan tud majd teljesíteni, az

a jövő egyik izgalmas kérdése lesz. Nyilván azon fog múlni, hogy az AMD mennyi

fejlesztőt tud a Mantle mellé állítani, és így mennyi játékban élvezhetjük majd

annak előnyeit - az Nvidia újdonságai ugyanis (igaz, más területet vesznek

célba, de) minden játékban hatásosak lesznek.

Nvidia Maxwell - titkos fegyver a Mantle ellen?

Kapcsolódó cikkek

Mármint van, de az azért van mert túl alacsony az fps a jelenlegi konzoloknál és nem ez végett a nem tudom minek hívják végett.

1280x1024 pl nalam siman megy a 100hz

..de ez is monitorfuggo

1. nem lesz minden monitormárkával elérhető

2. jó-jó, hogy a v-sync használata erőforrást igényel, de ez a modul a benne lévő hardver miatt kb egy pár tízezres vga kari ára, amit szerintem inkább az új vga árára pótolunk rá (így annak sem lesz akkora teher a v-sync)

3. mivel nvidia cucc, nem lesz egységes, szabványos, csak bizonyos játékok fogják támogatni, így világmegváltást nem remélhetünk tőle. Ez kb olyan, mint a Physics. Jó kis cucc, de simán lemondok róla bármikor, ha lassulást okoz az AMD-s konfigom miatt és nem érzem hiányát.

Ez megmarad az érdekesség szintjén még jó időre.

http://prohardver.hu/hir/nvidia_g-sync_technologia_monitor.html

"A G-Sync persze szabályok között működik, hiszen nem várhat a végtelenségig a képkockára. Van a rendszernek egy alapvető várakozási ideje, aminek a mértékéről nincs adat, de ha addig nem érkezik képkocka, akkor újra kirakja az aktuálisat. Ez természetesen akadást jelent, de az oka inkább a PC-n belüli folyamatokban keresendő, mintsem a szinkronban. Mindemellett a kijelző sem frissíthet mindent, tehát van egy maximális frissítési frekvencia is, aminek a mértéke szintén nem publikus, de ez nyilván egy logikus eleme a rendszernek. A G-Sync igazából arra jó, hogy a vertikális szinkron második bekezdésben leírt problémáját orvosolja. Ezzel a monitor működhet egy ideális 40-60 Hz közötti tartományban, ha a hardver például 40 és 60 képkocka/másodperces jellemző sebességet mutat fel."

A gaysync hozzáköti a monitort az nVidia hardvereihez, ami leginkább az nVidiának jó. Arról nem is beszélve, hogy ez nem több haszontalan, drága parasztvakításnál.

Ha nem vagy még tag, regisztrálj! 2 perc az egész.